企業正在迅速採用 AI。

他們在整個企業中部署 AI 應用程式和代理程式,而且通常缺乏

適當的安全防護,進而產生新的風險需要善加管理。

這種東拼西湊的單點解決方案無法因應 AI 保護的挑戰。

您需要貫穿整個 AI 生命週期的點對點

安全防護

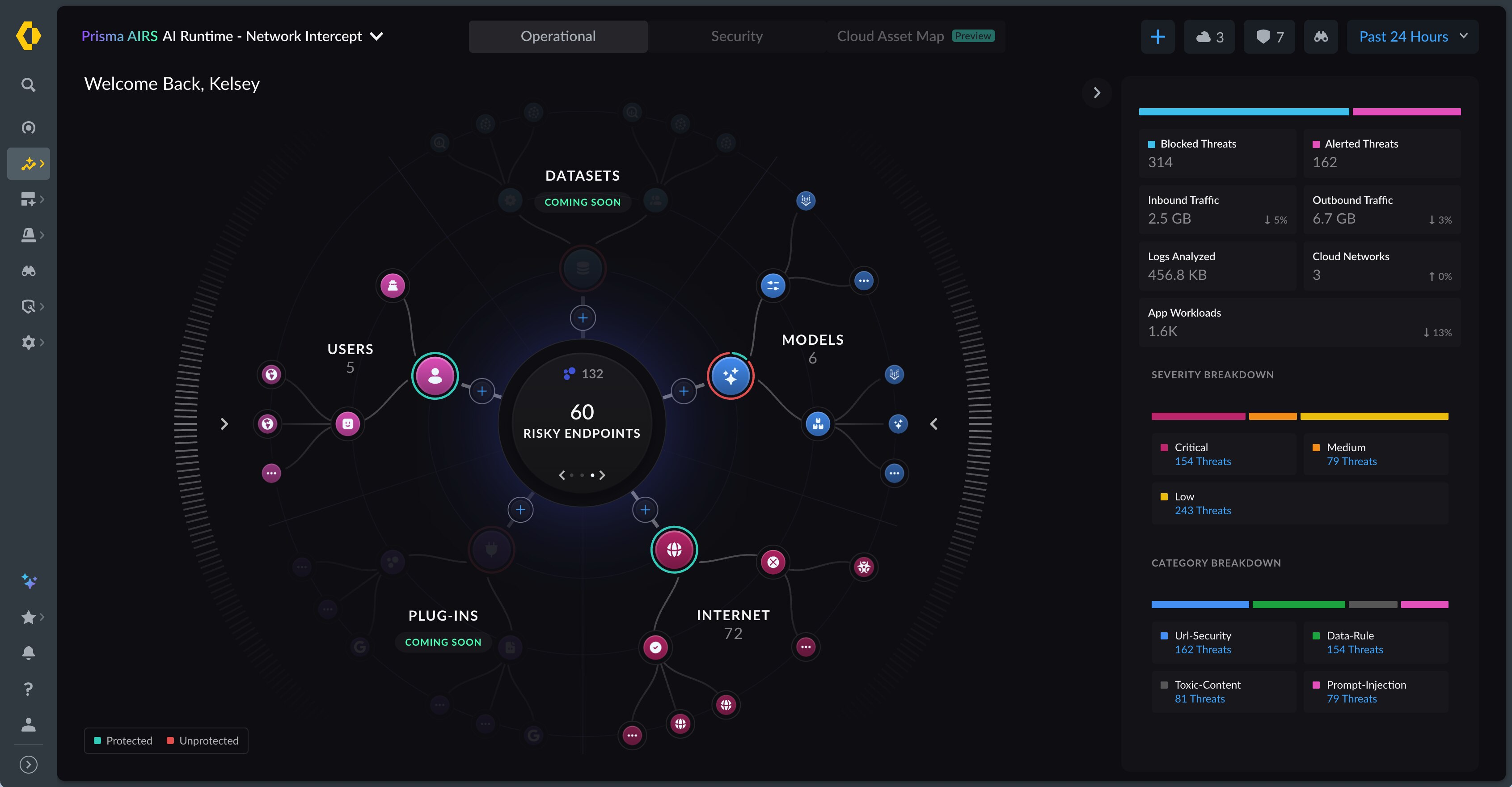

探索

您的 AI 生態系統。

取得對於 AI 基礎結構、平台和數據的可視性和控制力。

評估

您的 AI 風險。

儘早偵測弱點和風險,確保 AI 模型在部署之前安全無虞。

防範

各種威脅。

即時監控行為以偵測異常並阻止即時威脅。

Prisma AIRS 平台可保障從開發到部署的

所有應用程式、代理程式、模型和數據

的安全。

AI 模型安全防護

掃描第三方 AI 模型中的弱點以安全採用這些模型,並防範模型竄改、惡意指令碼與解序列化攻擊等風險,以保護您的 AI 生態系統。

AI 紅隊演練

先於惡意行動者發現潛在暴露與潛伏風險。使用我們的紅隊演練代理程式對您的 AI 應用程式與模型進行自動化滲透測試,以執行 AI 部署的壓力測試,就像真實攻擊者一樣學習及適應。

AI 安全狀況管理

取得對整個 AI 生態系統的全面可視性,以防止過度權限、敏感數據暴露、平台與存取錯誤設定等威脅。

AI Runtime Security

保護由 LLM 支援的 AI 應用程式、模型與數據免於遭受執行階段威脅的影響,例如提示植入、惡意程式碼、惡性內容、敏感數據洩漏、資源過載和幻覺攻擊等。

AI 代理程式安全防護

保護 AI 代理程式 (包括基於無程式碼/低程式碼平台所建構的代理程式),防範如身分冒用、記憶體操縱與工具濫用等各種新型代理式威脅。

最新的產品創新

我們正以 AI 的速度推動創新。查看 Prisma AIRS 中的新功能和更新。

自動化 AI 紅隊演練

透過 Prisma AIRS 的 AI 紅隊演練模擬真實攻擊、找出弱點,並在多種掃描模式下獲得詳細的風險評分。此功能可確保具彈性、安全的 AI 部署。

2025 年 10 月

AI 模型安全防護

利用 Prisma AIRS 的 AI 模型安全措施,確保只有安全且可信任的 AI 模型能進入生產環境。掃描模型以找出弱點、強制執行一致的安全標準,並維持合規性。此功能可保護 AI 生態系統中的每個模型。

2025 年 10 月

MCP 威脅偵測

透過 MCP 工具掃描如脈絡污染和數據洩漏等威脅,保護您的 AI 代理程式免於遭受供應鏈攻擊。此功能可確保安全、自主、基於 MCP 的 AI 作業。

2025 年 9 月

獨立 Prisma AIRS MCP 伺服器

透過 Prisma AIRS MCP 伺服器作為集中式閘道來部署安全、低程式碼的 AI 防護,以進行 AI 工具互動的掃描和驗證。此功能可簡化安全的 AI 整合。

2025 年 9 月

每個部署設定檔都能支援多個應用程式

利用單一安全設定檔與一致的政策來管理多達 20 個應用程式,以簡化監管程序並減少營運開支。每個部署設定檔都可以支援多個應用程式。

2025 年 9 月

統一的 AI 安全記錄

整合 AI 安全日誌與網路事件以消除片段化的可視性,為 SOC 提供單一管理平台以進行威脅偵測與回應。這可透過統一 Strata Cloud Manager 中的 AI 安全記錄來加以實現。

2025 年 8 月